DMflow.chat

廣告

DMflow.chat:智慧整合,創新溝通!除了持久記憶與客製欄位外,更支持真人與 AI 的靈活轉換,無縫連接資料庫與表單,讓網頁互動更靈活高效。

中國 AI 實驗室 DeepSeek 新發布的模型出現認知混亂,自稱 ChatGPT。本文將深入探討此現象的原因及其對 AI 發展的影響。

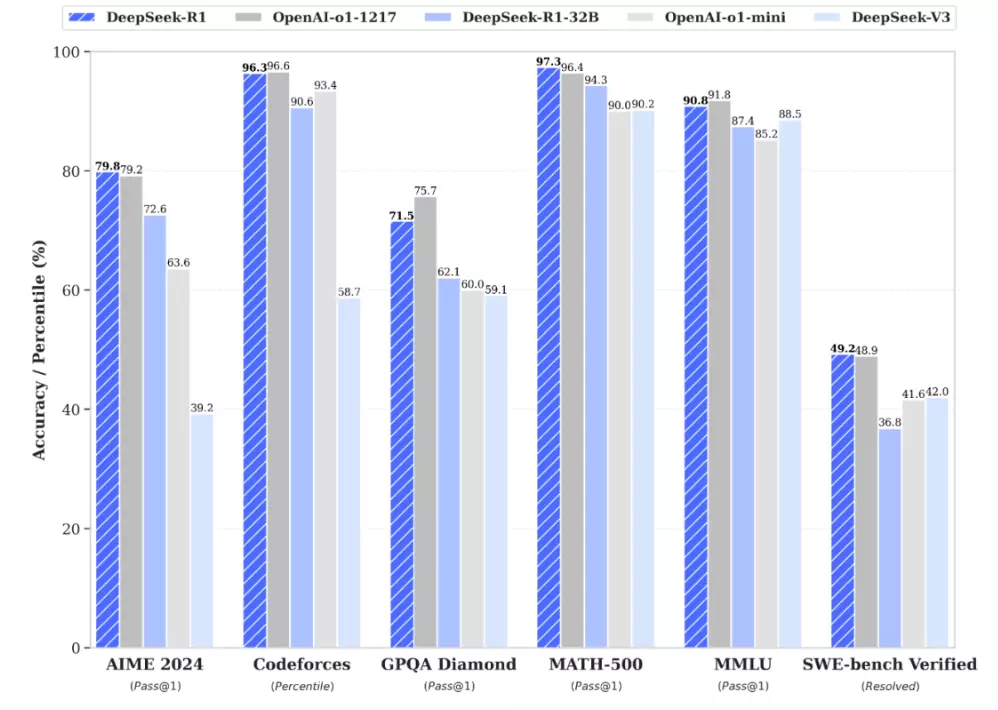

DeepSeek 近日發布了一款效能優異的開源 AI 模型 DeepSeek V3,號稱在多項基準測試中表現出色,能輕鬆處理編程和寫作等文本任務。然而,這個光環很快就蒙上了一層陰影:該模型竟然出現嚴重的身份認同混淆,離奇「冒認」自己是 ChatGPT,引發社群熱議。

現代 AI 模型本質上是複雜的統計系統,透過分析海量訓練數據來學習語言模式和知識。DeepSeek 雖然尚未公開其訓練數據的詳細來源,但考量到網路上充斥著大量 GPT-4 透過 ChatGPT 生成的文本數據,以及 AI 訓練資料日益匱乏的現況,專家推測 DeepSeek V3 極有可能在訓練過程中接觸到這些「受污染」的數據,導致出現類似人類「記憶」或「鸚鵡學舌」的效應,無法正確辨識自身身份。

隨著生成式 AI 的普及,網路上的內容越來越難以分辨是真人撰寫還是 AI 生成,這導致訓練數據中充斥著大量的「AI 垃圾」,也就是 AI 模型生成的文本。這種「AI 污染」使得模型難以學習到真正有用的知識,反而可能複製其他模型的錯誤或偏見,造成身份混淆。

這種身份混淆的現象可能源於兩種情況:

隨著生成式 AI 的蓬勃發展,網路上的內容越來越難以分辨真偽,這也為 AI 模型的訓練帶來了前所未有的挑戰。數據污染不僅影響模型的準確性和可靠性,更可能導致嚴重的倫理和社會問題。

通過「蒸餾」現有模型知識來降低成本的做法具有一定的吸引力,但這種做法可能帶來嚴重的後果,觸及法律和道德的底線。

Q1:為什麼 AI 模型會出現身份混淆?

A1: AI 模型,尤其是大型語言模型(LLM),本質上是透過分析海量數據來學習語言模式和知識的統計系統。當訓練數據中包含大量其他 AI 模型(例如 ChatGPT 或 GPT-4)的輸出時,模型便有可能學習到這些輸出的獨特風格、措辭習慣,甚至是特定的回答內容,從而產生身份混淆,誤以為自己就是那個模型。這種現象的成因主要有以下幾點:

Q2:這種現象會帶來什麼影響?

A2: AI 模型身份混淆不僅是一個技術問題,更可能帶來一系列嚴重的影響:

Q3:如何避免類似問題?

A3: 避免 AI 模型身份混淆需要多方面的努力:

DMflow.chat:智慧整合,創新溝通!除了持久記憶與客製欄位外,更支持真人與 AI 的靈活轉換,無縫連接資料庫與表單,讓網頁互動更靈活高效。

DeepSeek-V3-0324 震撼發布:免費商業使用,支援消費級設備! 簡介 DeepSeek 再次以低調但震撼業界的方式推出了最新的大型語言模型——DeepSeek-V3-0324。這款...

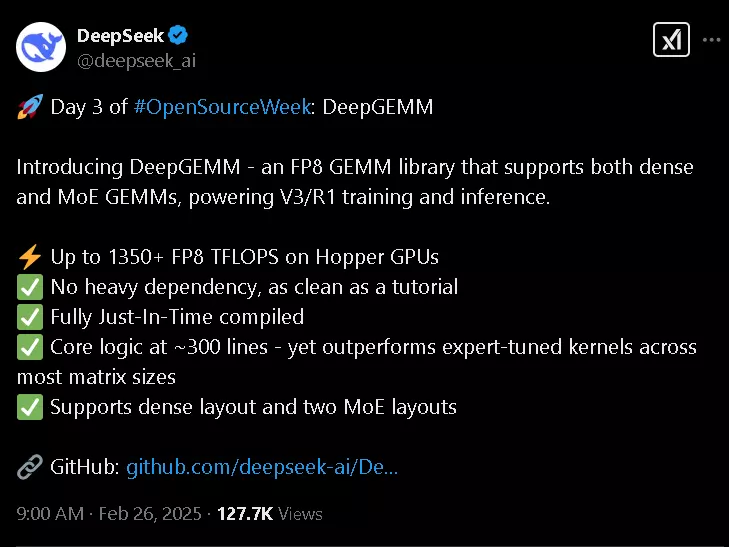

DeepSeek 開源週第三天:推出 DeepGEMM — AI 訓練與推理的新利器 什麼是 DeepGEMM? DeepSeek 在其「開源週」第三天正式推出 DeepGEMM,這款開源函式...

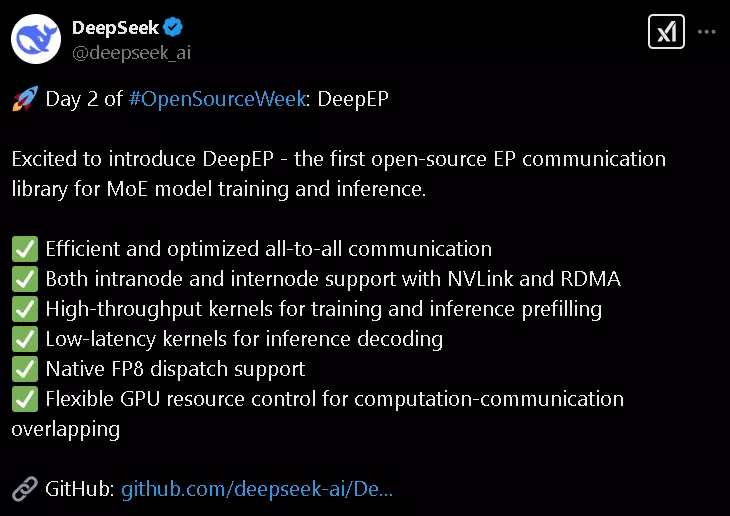

DeepSeek 推出了 DeepEP,MoE 模型訓練的秘密武器 嘿,各位,最近 DeepSeek 開源社群可熱鬧了!他們在 #OpenSourceWeek 的第二天,就丟出了一個超厲...

3000GB/s?DeepSeek 的新工具正在改變大型語言模型的遊戲規則 DeepSeek 剛剛釋出了一個超級令人興奮的消息!今天是他們「開源週」的第一天,他們一開始就來個震撼彈 ——...

DeepSeek R1:開源 AI 模型革命,挑戰 OpenAI 霸主地位 中國 AI 實驗室 DeepSeek 推出全新開源推理模型 DeepSeek R1,不僅在多項基準測試中與 O...

DeepSeek R1T Chimera 登陸 OpenRouter!AI 界新寵兒,智慧與效率的完美融合? 最新開源 AI 模型 DeepSeek R1T Chimera 震撼登場 O...

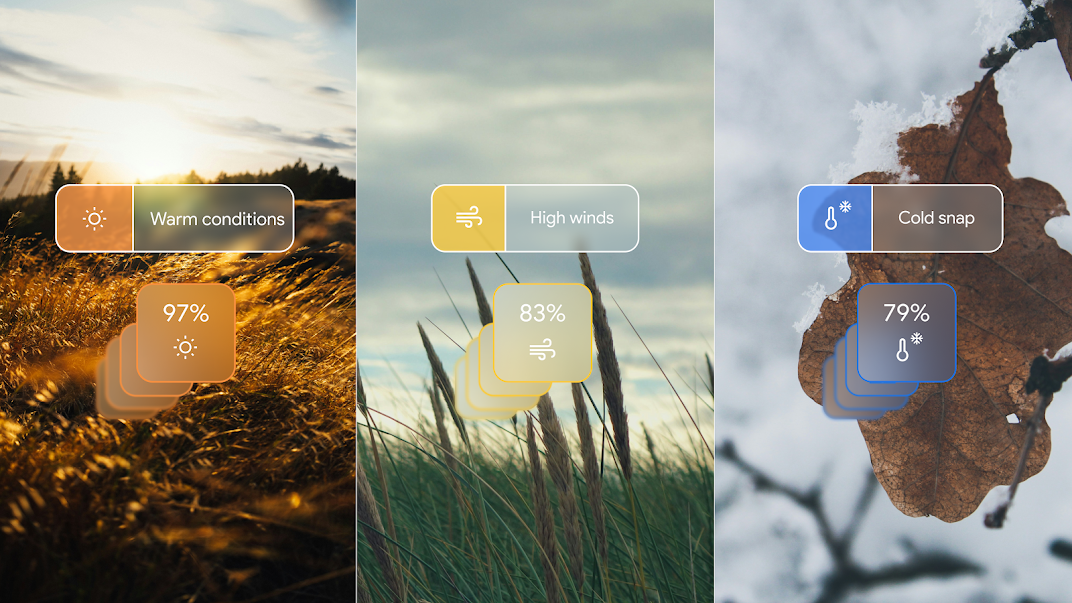

Google GenCast:突破天際的 AI 天氣預測新時代 描述 Google GenCast 是一款創新的 AI 天氣預測模型,能以高精度預測 15 天內的天氣狀況與極端天氣風險。本文將...

Gemini的重大升級:1.5 Flash帶來更快回應、擴展訪問等功能 Google宣布Gemini人工智能助手的重大更新,包括在40多種語言和230多個國家和地區推出1.5 Flash版本,...

突破性進展:OpenAI擴大o1模型使用限制,免費和付費用戶均受益 OpenAI最新公告擴大o1模型使用限制,為AI愛好者和專業人士帶來更多機會。本文深入探討這一重大更新對不同用戶群體的影響,...

By continuing to use this website, you agree to the use of cookies according to our privacy policy.