DMflow.chat

廣告

一站整合多平台聊天,體驗真人與 AI 自由切換的新境界!支援 Facebook、Instagram、Telegram、LINE 及網站,結合歷史記錄、推播通知、行銷活動及客服轉接,全面提升效率與互動。

DeepSeek 在其「開源週」第三天正式推出 DeepGEMM,這款開源函式庫支援 FP8 通用矩陣乘法 (GEMM),專為 密集型與專家混合模型 (MoE) 矩陣運算 而設計。這項工具強力支援 DeepSeek 的旗艦模型 — DeepSeek V3 和 R1 的訓練與推理。

但 DeepGEMM 究竟有什麼獨特之處?我們來仔細看看。

根據 DeepSeek 官方在 X (前身為 Twitter) 上的公告,DeepGEMM 在 NVIDIA Hopper GPU 上的 FP8 運算效能高達 1350+ TFLOPS。更令人驚豔的是,其核心邏輯僅約 300 行程式碼,在簡單與高速間取得了巧妙平衡。

以下是 DeepGEMM 的亮點功能:

在 AI 模型訓練中,效能至關重要,而 DeepGEMM 的表現毫不遜色。事實上,在多種矩陣尺寸下,它的效能不僅與 專家級調校函式庫 並駕齊驅,甚至有所超越。

| M | N | K | 運算效能 (TFLOPS) | 加速比 |

|---|---|---|---|---|

| 64 | 2112 | 7168 | 206 | 2.7x |

| 128 | 2112 | 7168 | 352 | 2.4x |

| 4096 | 2112 | 7168 | 1058 | 1.1x |

| 群組數 | 每群組 M | N | K | 運算效能 (TFLOPS) | 加速比 |

|---|---|---|---|---|---|

| 1 | 1024 | 4096 | 7168 | 1233 | 1.2x |

| 2 | 512 | 7168 | 2048 | 916 | 1.2x |

| 4 | 256 | 4096 | 7168 | 932 | 1.1x |

儘管 DeepGEMM 的表現令人驚豔,團隊也坦言部分矩陣尺寸的效能仍有進步空間。他們誠摯邀請開發者提交 優化 Pull Requests (PR),共同提升這套工具。

DeepSeek 不僅在打造自己的工具,更在推動 開源合作。透過釋出 DeepGEMM,他們讓全球開發者有機會共同推動 AI 訓練與推理的技術發展。不僅侷限於 DeepSeek 的模型,這是一場全球性的技術生態合作。

此外,對於想深入研究 FP8 矩陣運算的人來說,DeepGEMM 的簡潔設計讓你可以毫無障礙地探索 Hopper tensor cores,而無需陷入過度工程化的程式碼泥沼。

想試試看 DeepGEMM 嗎?以下是基本需求:

需求條件:

詳細專案與安裝指南請見:DeepGEMM 在 GitHub

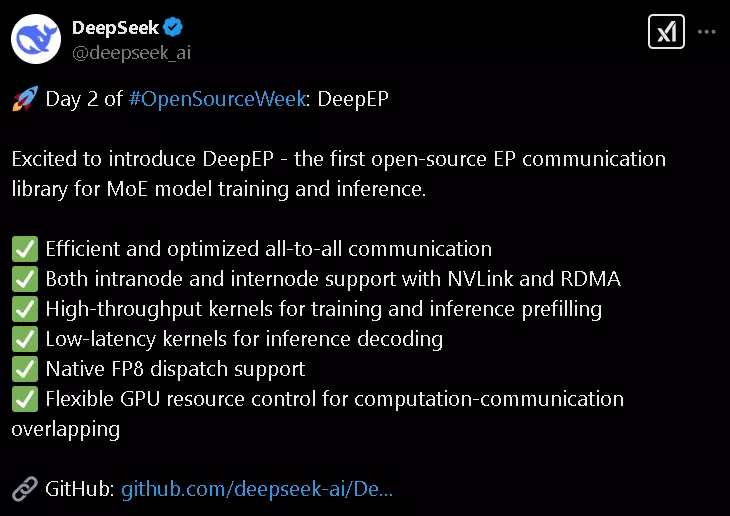

DeepSeek 的開源週已經發布了 FlashMLA (快速語言模型架構) 與 DeepEP (專家平行通訊),如今又透過 DeepGEMM 穩固了其在 AI 基礎建設領域的地位。

但這僅僅是個開始。有了社群的參與與優化,DeepGEMM 不僅能提升 DeepSeek 的模型效能,更可能成為全球 AI 研究人員的強大工具。

準備好一起探索 FP8 GEMM 的無限可能了嗎?讓我們攜手構築 AI 的未來,一個矩陣運算接著一個。

一站整合多平台聊天,體驗真人與 AI 自由切換的新境界!支援 Facebook、Instagram、Telegram、LINE 及網站,結合歷史記錄、推播通知、行銷活動及客服轉接,全面提升效率與互動。

DeepSeek-V3-0324 震撼發布:免費商業使用,支援消費級設備! 簡介 DeepSeek 再次以低調但震撼業界的方式推出了最新的大型語言模型——DeepSeek-V3-0324。這款...

DeepSeek 推出了 DeepEP,MoE 模型訓練的秘密武器 嘿,各位,最近 DeepSeek 開源社群可熱鬧了!他們在 #OpenSourceWeek 的第二天,就丟出了一個超厲...

3000GB/s?DeepSeek 的新工具正在改變大型語言模型的遊戲規則 DeepSeek 剛剛釋出了一個超級令人興奮的消息!今天是他們「開源週」的第一天,他們一開始就來個震撼彈 ——...

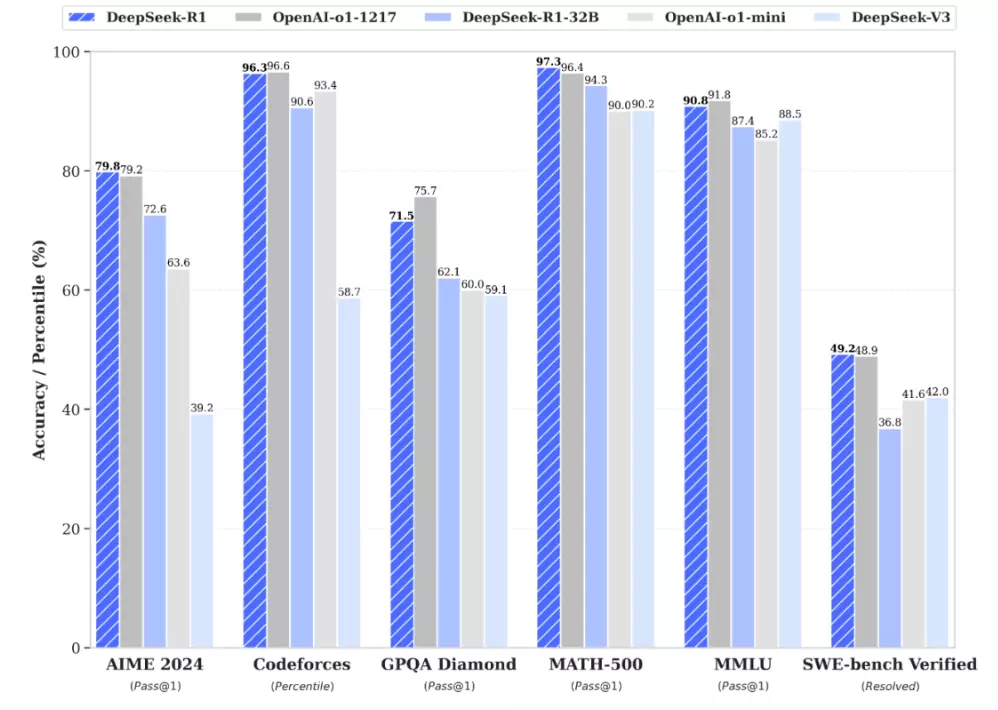

DeepSeek R1:開源 AI 模型革命,挑戰 OpenAI 霸主地位 中國 AI 實驗室 DeepSeek 推出全新開源推理模型 DeepSeek R1,不僅在多項基準測試中與 O...

DeepSeek V3 引發爭議:中國 AI 模型為何自稱是 ChatGPT? 中國 AI 實驗室 DeepSeek 新發布的模型出現認知混亂,自稱 ChatGPT。本文將深入探討此現象...

DeepSeek R1T Chimera 登陸 OpenRouter!AI 界新寵兒,智慧與效率的完美融合? 最新開源 AI 模型 DeepSeek R1T Chimera 震撼登場 O...

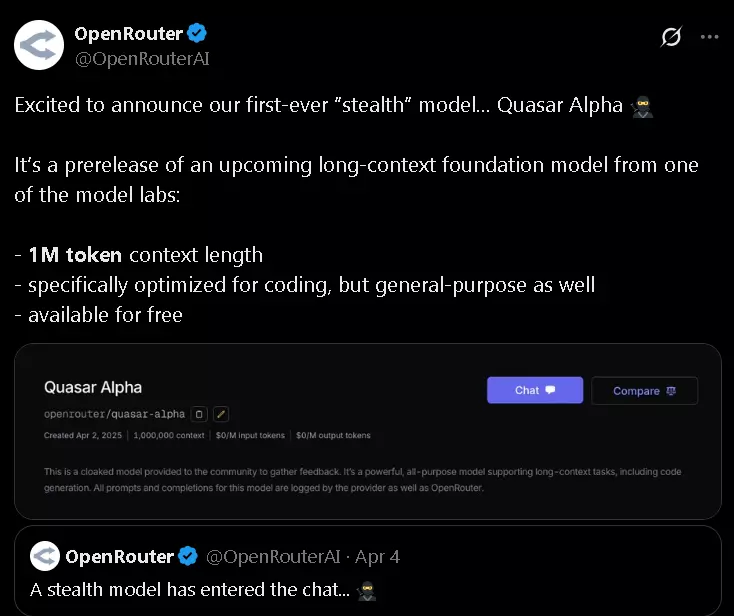

秘密武器登場?OpenRouter 無預警釋出百萬級長上下文模型 Quasar Alpha! AI 界又有新玩具了!OpenRouter 悄悄推出了一款名為 Quasar Alpha 的...

2024年免費商用授權AI大模型:基礎大模型全面分析 本文全面分析了2024年發布的多個免費商用授權基礎大模型,包括Gemma 2、Phi-3-small、Llama3系列、Grok-1等。我...

DeepSeek 推出全新多模態 AI 模型 Janus-Pro,效能超越 DALL-E 3 DeepSeek 這家近期爆紅的 AI 公司,發布了一系列全新的多模態 AI 模型,名為 J...

By continuing to use this website, you agree to the use of cookies according to our privacy policy.