DMflow.chat

廣告

DMflow.chat:智慧客服新時代,輕鬆切換真人與 AI!持久記憶、客製欄位、即接資料庫表單,多平台溝通,讓服務與行銷更上一層樓。

在 AI 發展突飛猛進的時代,大型語言模型(LLM)的事實準確性一直是業界關注的焦點。最新發布的 FACTS Grounding 評測基準,為解決 AI 幻覺問題帶來重大突破,透過全面的測試方法論和線上排行榜,為產業提供了準確評估 LLM 事實性的重要工具。

隨著大型語言模型在各領域的應用日益普及,其產生「幻覺」(hallucination)的問題也越發引起關注。所謂幻覺,指的是模型生成與事實不符的資訊,這不僅影響使用者體驗,更可能導致嚴重的信任危機。

FACTS Grounding 評測基準的出現,正是為了解決這個關鍵問題。這套評測系統不僅考察模型的事實準確性,更注重評估模型是否能夠:

該評測基準包含 1,719 個精心設計的測試樣本,分為兩大類:

測試樣本涵蓋多個重要領域:

每個文件最多可包含 32,000 個標記(約 20,000 字),確保測試的深度和廣度。

FACTS Grounding 採用三個頂尖 LLM 作為評判:

這種多重評判機制的設計可以:

Q1: FACTS Grounding 與其他評測基準有何不同? A1: FACTS Grounding 特別強調長篇回答的事實準確性,並採用多重 AI 評判機制,這是業界首創的評測方式。

Q2: 如何參與 FACTS Grounding 評測? A2: 開發者可以使用公開的測試集進行自評,或將模型提交至 Kaggle 上的 FACTS 排行榜進行正式評測。

Q3: FACTS Grounding 會持續更新嗎? A3: 是的,該評測基準將根據 AI 領域的進展不斷演進,持續提高評測標準。

FACTS Grounding 的發布標誌著 AI 事實性評測領域的重要里程碑。隨著技術的發展,該評測基準也將持續更新,以適應新的挑戰和需求。我們期待看到:

這個創新的評測基準不僅推動了 AI 技術的進步,更為建立用戶對 AI 系統的信任提供了重要保障。

DMflow.chat:智慧客服新時代,輕鬆切換真人與 AI!持久記憶、客製欄位、即接資料庫表單,多平台溝通,讓服務與行銷更上一層樓。

限時七天!Windsurf AI 震撼推出免費無限 GPT-4.1 試用,立即體驗頂尖 AI!(2025-0414-0421) AI 界的朋友們注意!Windsurf AI 宣布提供為期...

偷聽海豚說話?Google AI 神器 DolphinGemma 揭開海洋世界的溝通秘密 幾十年來,科學家們一直試圖解開海豚那複雜的「喀答聲」、「哨聲」和「脈衝聲」之謎。現在,Googl...

WordPress 放大絕!一句話打造專屬網站?AI 助手讓你跟架站煩惱說掰掰! 厭倦了複雜的網站架設流程?WordPress 推出革命性 AI 網站建置工具,只要一句話描述你的想法,A...

AI 智慧體大串連!Google 推出開源 A2A 協定,打造無縫協作新時代 厭倦了各自為政的 AI 工具嗎?Google 攜手 50 多家科技巨頭推出 Agent2Agent (A2A...

Llama 4 偷跑學習?Meta 高層駁斥作弊指控,揭開 AI 模型訓練的灰色地帶 Meta 最新 AI 模型 Llama 4 一推出就引發軒然大波!被指控在訓練過程中「作弊」以美化評...

Meta 震撼彈!開源 Llama 4 多模態 AI 登場,效能驚人挑戰 GPT-4! Meta 最新力作 Llama 4 系列 AI 模型正式開源!原生多模態、超長上下文、專家混合架構...

Microsoft TRELLIS:AI 驅動的高品質 3D 資產生成平台 簡介 Microsoft TRELLIS 是一種基於 AI 的先進 3D 模型生成工具,可將文字或圖像提示轉換為精細...

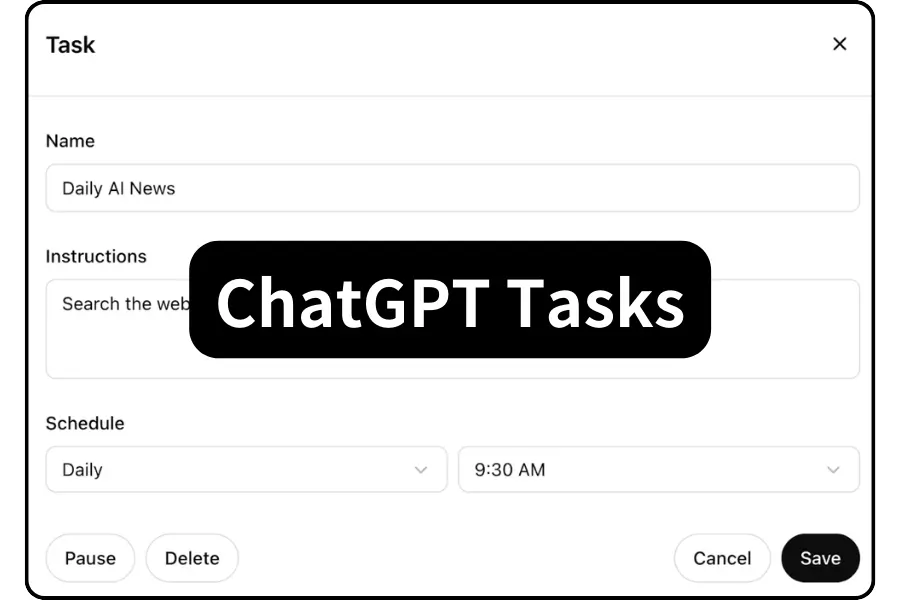

ChatGPT 排程任務完整使用指南:讓 AI 助理自動化完成您的日常工作 前言:為什麼需要 ChatGPT 排程任務? 在現代數位工作環境中,自動化已成為提升工作效率的關鍵。ChatGPT...

Claude AI 重大更新:新增網頁搜尋功能,提升即時資訊獲取能力 Claude AI 進入即時資訊時代 Anthropic 最近宣布,旗下 AI 聊天機器人 Claude 現已具備網頁搜...

By continuing to use this website, you agree to the use of cookies according to our privacy policy.