MMLU 測試揭露大型語言模型的真實實力與侷限

核心摘要

當今最先進的人工智慧模型是否真能與人類專家一較高下?MMLU(大規模多任務語言理解測試,Massive Multitask Language Understanding)為我們提供了一個嚴謹的評估標準。MMLU 是一個涵蓋廣泛知識領域的基準測試,包含 STEM(科學、技術、工程、數學)、人文科學、社會科學等 57 個學科,從數學和歷史等傳統領域到法律和倫理等更專業的領域皆有涵蓋。這項測試不僅考驗模型對於世界知識的掌握程度,更著重於評估其解決問題和深度推理的能力,而非僅是表面文字的匹配或關鍵字檢索。本文將深入剖析 MMLU 測試系統,揭示 AI 在跨學科知識應用上的現況、優勢與挑戰,以及此類測試對於推動 AI 技術發展的重要性。透過了解 MMLU 的評估方式和結果,我們可以更清晰地認識到大型語言模型的真正實力與其仍存在的侷限性。

1. MMLU:突破性的 AI 能力評測系統

全名:Massive Multitask Language Understanding(大規模多任務語言理解)

1.1 緣起與重要性

在人工智慧(AI)技術突飛猛進的時代,我們迫切需要一套更全面、更嚴謹的評估系統,以準確衡量 AI 模型的真實能力,特別是在複雜知識的理解和應用方面。過去的評測方法往往側重於單一任務或特定領域的表現,難以反映 AI 在實際應用中的泛化能力和解決複雜問題的能力。MMLU(大規模多任務語言理解)正是在這樣的背景下應運而生,它填補了既有評測方法的不足,提供了一個更具挑戰性、更貼近人類認知能力的評估框架,為 AI 模型的實際應用能力提供更準確、更可靠的衡量標準。透過 MMLU 的評估結果,研究人員和開發者可以更有效地改進模型,推動 AI 技術的發展,並更好地理解 AI 的潛力與限制。

1.2 創新特點

MMLU 與傳統評測方法最大的不同在於其多維度的評估方法,它不僅僅是檢測模型的記憶能力,更著重於評估其理解、推理和應用知識的能力。以下是 MMLU 的幾個主要創新特點:

- 跨領域知識整合: MMLU 涵蓋了 STEM(科學、技術、工程、數學)、人文科學、社會科學等廣泛領域的 57 個學科,從數學、物理等傳統學科到法律、倫理等專業領域均有涵蓋。這種廣泛的覆蓋範圍要求模型具備整合不同領域知識的能力,更貼近現實世界中複雜的問題解決場景。

- 實際場景應用導向: MMLU 的題目設計更貼近實際應用場景,考驗模型如何運用所學知識解決真實世界的問題,而非僅僅是回答教科書上的定義或概念。這使得評估結果更具實用價值,更能反映模型在實際應用中的表現。

- 零樣本(Zero-shot)和少樣本(Few-shot)學習能力測試: MMLU 主要採用零樣本和少樣本的方式評估模型。零樣本是指模型在沒有任何相關範例的情況下直接回答問題,而少樣本則是提供少量的範例供模型參考。這種評估方式更貼近人類的學習方式,更能有效檢驗模型的泛化能力和推理能力。

- 專業知識深度評估: MMLU 的題目難度從初級到專業高級不等,包含許多需要深入專業知識才能回答的問題。這使得 MMLU 不僅能評估模型對基礎知識的掌握程度,更能深入評估其在特定領域的專業知識水平。

MMLU 的核心優勢之一在於其廣泛的知識領域覆蓋,它精心設計的 57 個測試領域涵蓋了人文社科、理工醫學、商業與應用等多個範疇,旨在全面評估 AI 模型在不同學科的知識掌握和應用能力。

2.1 學科分類詳解

MMLU 的 57 個測試領域可大致分為以下幾類:

人文社科類:

- 歷史學: 涵蓋古今中外的重要事件、人物、文化、政治和社會發展脈絡,例如古代文明的興衰、重要戰爭的影響、歷史人物的貢獻等,考驗模型對歷史事實的理解和分析能力。

- 哲學: 包含東西方哲學思想體系、倫理學、形而上學、邏輯推理等,例如重要的哲學家及其思想、倫理困境的分析、邏輯論證的評估等,考驗模型的思辨能力和抽象思維能力。

- 法律: 涵蓋各國法規體系、法律原則、案例分析、法律術語等,例如合同法、刑法、憲法等不同法律領域的知識,考驗模型對法律條文的理解和應用能力。

- 政治學: 涵蓋政治理論、政治制度、國際關係、公共政策等,例如不同政治制度的比較、國際關係的演變、公共政策的制定和影響等,考驗模型對政治現象的分析和理解能力。

理工醫學類:

- 數學: 從基礎運算、代數、幾何,到高等數學的微積分、線性代數、概率論等,考驗模型在數學概念理解和問題解決方面的能力。

- 物理: 涵蓋古典力學、電磁學、熱力學、量子力學等理論物理與實驗應用,考驗模型對物理定律的理解和應用能力。

- 化學: 涵蓋有機化學、無機化學、物理化學等,考驗模型對化學物質、反應和原理的理解。

- 生物學: 涵蓋分子生物學、細胞生物學、遺傳學、生態學等,考驗模型對生物學概念和生命現象的理解。

- 醫學: 涵蓋解剖學、生理學、病理學、藥理學、臨床診斷與治療方案等,考驗模型在醫學知識和臨床實踐方面的理解和應用能力。

- 電腦科學: 涵蓋演算法、資料結構、程式設計、人工智慧等,考驗模型在電腦科學領域的知識和應用能力。

- 工程學: 涵蓋不同工程領域的知識,例如機械工程、電子工程、土木工程等。

商業與應用類:

- 經濟學: 涵蓋微觀經濟學、宏觀經濟學、市場理論、金融學等,考驗模型對經濟現象和市場運作的理解和分析能力。

- 企業管理: 涵蓋組織行為、決策制定、人力資源管理、戰略管理等,考驗模型在企業管理方面的知識和應用能力。

- 市場營銷: 涵蓋市場調查、品牌管理、行銷策略規劃與執行、消費者行為等,考驗模型在市場行銷方面的知識和應用能力。

- 會計學: 涵蓋財務會計、管理會計等,考驗模型對會計原則和財務報表的理解。

其他:

MMLU 還包含其他一些領域,例如:

- 倫理學: 考驗模型在倫理道德方面的判斷和推理能力。

- 常識推理: 考驗模型對日常生活常識的理解和應用能力。

3. 測試設計與評分機制

MMLU 的測試設計和評分機制旨在提供一個客觀、全面且嚴謹的評估框架,以準確衡量 AI 模型在不同知識領域的理解和應用能力。

3.1 題型設計原則

MMLU 的題型設計遵循以下原則,以確保評估的有效性和可靠性:

- 多元選擇題格式確保客觀評估: MMLU 主要採用多元選擇題(Multiple Choice Question)的格式,每個問題提供多個選項,模型需要從中選擇正確答案。這種格式的優點在於評分客觀、易於量化,可以有效避免主觀判斷帶來的偏差。雖然有些研究指出多選題可能存在一些限制,例如猜測的機率,但 MMLU 在設計題目時會盡量避免選項過於相似或容易猜測的情況,以提高評估的準確性。

- 難度分級系統反映真實專業水平: MMLU 的題目難度從初級到專業高級不等,涵蓋了高中、大學甚至研究生水平的知識。這種難度分級系統使得 MMLU 能夠更精準地評估模型在不同專業領域的知識掌握程度,並區分模型在處理不同難度問題時的表現。例如,在數學領域,題目可能包含基礎的四則運算、代數方程,也可能包含微積分、線性代數等高等數學的題目。

- 問題情境貼近實際應用場景: MMLU 的題目設計注重實際應用,許多題目都設定了真實世界的情境,要求模型運用所學知識解決實際問題。這種設計方式更能反映模型在實際應用中的表現,也更能體現模型是否真正理解了相關知識,而不僅僅是死記硬背。例如,在法律領域,題目可能描述一個具體的案例,要求模型根據相關法律條文進行分析和判斷。

3.2 評分標準

MMLU 的評分主要基於答案的準確度,但也考慮到其他因素,以更全面地評估模型的表現:

- 答案準確度: 這是最主要的評分標準,模型選擇的答案與標準答案一致則得分,否則不得分。MMLU 會統計模型在每個學科和所有學科的準確度,作為評估模型能力的重要指標。

- 推理過程完整性 (在某些變體或後續研究中): 雖然 MMLU 本身主要以選擇題評分,但後續的一些研究或變體可能會要求模型提供推理過程的說明,以更深入地了解模型的解題思路。這部分評分會根據推理過程的完整性、合理性和邏輯性進行評估。這在評估大型語言模型的「思維鏈 (Chain-of-Thought)」能力時尤為重要。

- 跨領域知識整合能力 (隱含在測試設計中): 雖然 MMLU 沒有單獨針對跨領域知識整合能力進行評分,但由於其涵蓋了廣泛的學科領域,模型若要取得好的成績,就必須具備整合不同領域知識的能力。因此,跨領域知識整合能力是隱含在測試設計中的一個重要考量。

MMLU 測試不僅展現了 AI 模型的強大能力,也突顯了其與人類專家之間的差距。透過分析最新的測試結果,我們可以更清晰地了解 AI 在哪些方面表現出色,又在哪些方面仍有進步的空間。

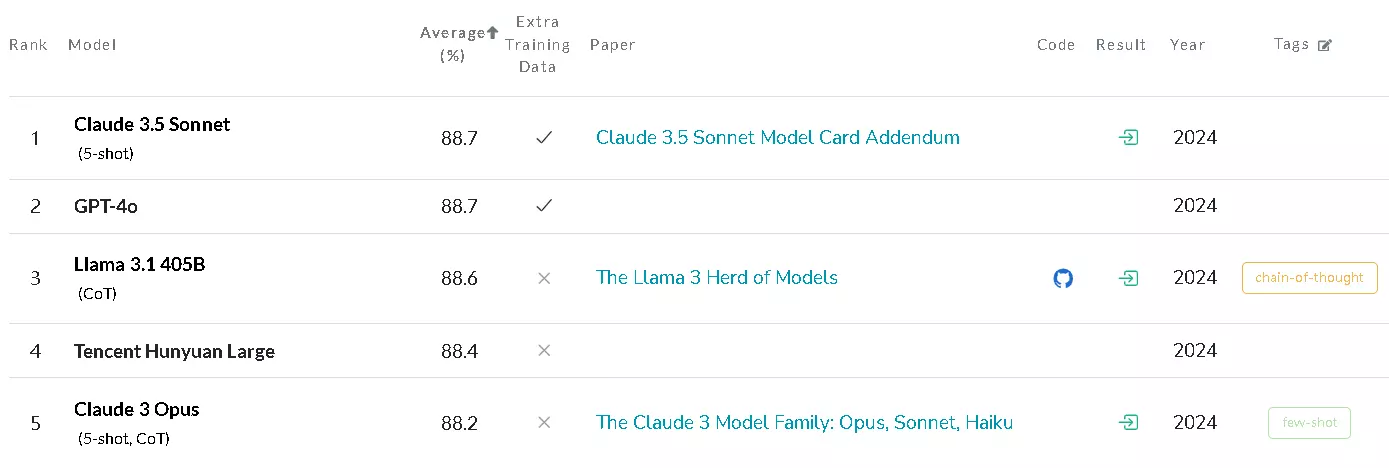

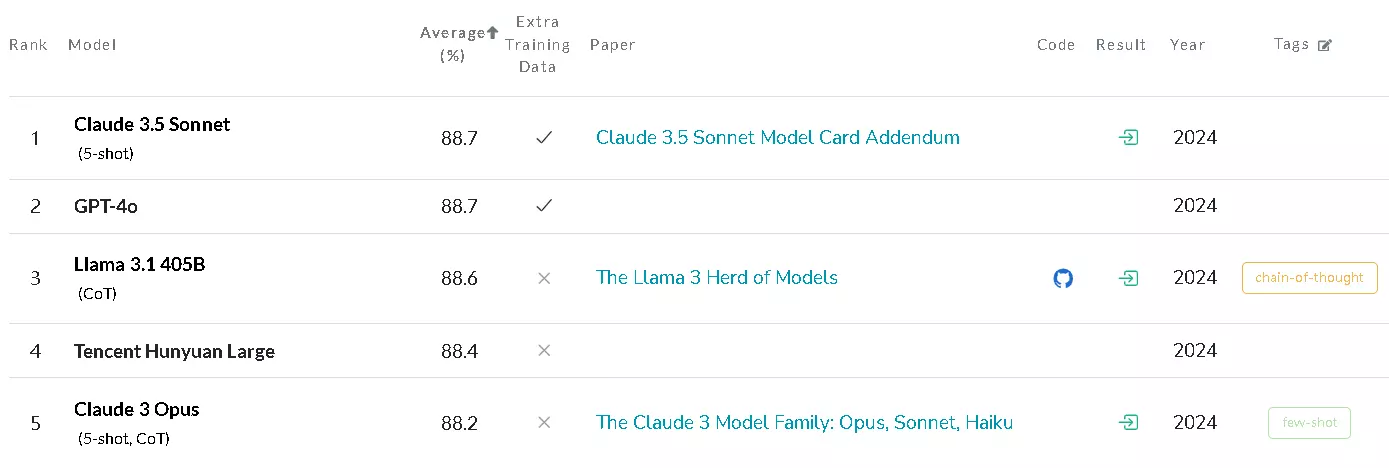

4.1 最新測試結果

根據最新的 MMLU 測試結果,目前最先進的 AI 模型表現如下:

- GPT-4: 接近 86.4% 的準確度,在多個領域展現了卓越的性能,逼近人類專家的水平。

- Claude: 約 81.8% 的準確度,表現出色,但與 GPT-4 仍存在一定差距。

- PaLM: 約 78.3% 的準確度,展現了良好的基礎能力,但在某些需要深度推理和複雜知識整合的領域表現稍遜。

作為對比,人類專家的平均水平約為 89.8%。這表明,雖然最先進的 AI 模型在某些方面已經非常接近人類,但在整體表現上仍然存在一定的差距。值得注意的是,這些數據可能會隨著模型的更新和測試的進行而變化。

4.2 領域差異分析

透過更深入的分析,我們可以發現 AI 和人類在不同領域的表現存在顯著差異:

AI 表現突出的領域:

- 事實性知識檢索: AI 模型在處理事實性知識檢索方面表現出色,能夠快速準確地從大量的資料庫中提取相關資訊。這得益於其龐大的訓練數據和高效的檢索演算法。

- 標準化流程判斷: 對於遵循明確規則和標準化流程的判斷問題,AI 模型也能夠高效地完成。例如,根據法律條文進行案例分析、根據醫學指南進行診斷等。

- 邏輯推理問題 (在一定程度上): 在一些結構化的邏輯推理問題上,AI 模型也能展現出一定的能力,例如數獨、邏輯填空等。然而,對於需要更複雜的推理、抽象思維和常識判斷的問題,AI 模型仍然面臨挑戰。

人類優勢明顯的領域:

- 創意思維: 創意思維是人類獨特的優勢之一。人類能夠產生新穎的想法、提出獨特的解決方案,並進行藝術創作等。目前,AI 模型在創意思維方面仍然難以匹敵人類。

- 道德判斷: 道德判斷涉及複雜的價值觀、倫理觀和社會規範,需要考慮多方面的因素和潛在的影響。目前,AI 模型在進行道德判斷時仍然存在許多挑戰,容易受到數據偏差和演算法限制的影響。

- 跨領域整合: 人類能夠有效地整合不同領域的知識,並將其應用於解決複雜的問題。這種跨領域整合能力是 AI 模型目前較為薄弱的環節。雖然 MMLU 測試本身就考驗了模型的跨領域知識整合能力,但人類在整合不同領域的知識、並將其應用於新的情境時,仍然展現出明顯的優勢。

- 常識推理和情境理解: 人類擁有豐富的生活經驗和常識,能夠根據情境快速理解問題的含義,並做出合理的判斷。AI 模型在常識推理和情境理解方面仍然存在不足,容易受到字面意思的干擾,難以理解問題的深層含義。

- 情感和同理心: 人類擁有豐富的情感和同理心,能夠理解他人的感受,並做出恰當的回應。這是 AI 模型目前難以模擬的。

MMLU 測試不僅展現了大型語言模型的巨大潛力,也揭示了其在發展過程中仍然面臨的諸多挑戰。正視這些挑戰並積極尋求解決方案,是推動 AI 技術持續進步的關鍵。

5.1 技術瓶頸

儘管大型語言模型在 MMLU 測試中取得了令人矚目的成績,但它們仍然存在一些重要的技術瓶頸:

- 深度推理能力不足: 儘管模型在一些結構化的邏輯推理問題上表現出一定的能力,但在需要複雜推理、抽象思維、常識判斷和因果關係理解的問題上,仍然存在明顯的不足。模型往往難以理解問題的深層含義,也難以將不同的知識點有效地聯繫起來進行推理。例如,模型可能能夠回答關於歷史事件的具體時間和地點的問題,但難以理解這些事件之間的因果關係和對後世的影響。

- 知識更新時效性問題: 大型語言模型的知識主要來自於其訓練數據,而訓練數據通常是靜態的。這導致模型難以及時更新知識,容易產生知識滯後的問題。例如,如果訓練數據中沒有包含最新的科學發現或時事新聞,模型就無法回答相關的問題。如何建立更有效的知識更新機制,使模型能夠及時學習和整合新知識,是一個重要的挑戰。

- 跨文化理解障礙: 由於訓練數據的偏差,大型語言模型在跨文化理解方面常常存在障礙。模型可能更熟悉某些文化背景下的知識和表達方式,而對其他文化背景下的知識和表達方式理解不足,甚至產生誤解。這限制了模型在全球範圍內的應用。

- 缺乏真正的理解和意識: 儘管模型可以通過大量的數據學習到語言的模式和規律,並在 MMLU 等測試中取得高分,但它們仍然缺乏像人類一樣的真正理解和意識。模型只是在模仿人類的語言行為,而沒有像人類一樣的內在體驗和意識。

5.2 發展方向

為了克服上述挑戰,大型語言模型的未來發展需要重點關注以下幾個方向:

- 強化模型推理深度: 開發更先進的推理演算法和模型架構,使模型能夠進行更複雜的推理、抽象思維和常識判斷。例如,研究人員正在探索使用圖神經網路、知識圖譜等技術來增強模型的推理能力。同時,發展更有效的評估方法,以更準確地衡量模型的推理能力,也至關重要。

- 提升知識更新機制: 研究更有效的知識更新方法,使模型能夠及時學習和整合新知識。例如,可以探索使用持續學習、增量學習等技術,使模型能夠在不重新訓練整個模型的情況下,不斷學習新的知識。此外,建立更完善的知識庫和數據管道,也是提升知識更新效率的重要途徑。

- 增強跨文化適應性: 擴展訓練數據的多樣性,包含更多不同文化背景下的數據,以減少模型在跨文化理解方面的偏差。同時,研究更有效的跨文化學習方法,使模型能夠更好地理解和適應不同的文化背景。

- 探索更接近人類的學習方式: 研究如何使模型更像人類一樣學習,例如通過互動、體驗和實踐來學習,而不僅僅是通過大量的數據學習。這可能需要結合其他 AI 技術,例如機器人學、電腦視覺等,來構建更智能的系統。

- 提高模型的可解釋性和透明度: 目前,大型語言模型通常被視為「黑盒子」,人們難以理解其內部的工作機制。提高模型的可解釋性和透明度,有助於人們更好地理解模型的優勢和局限,並建立對模型的信任。

6. 實務應用指南

MMLU 作為一個全面評估 AI 模型能力的基準測試,其評估方法和結果也具有重要的實務應用價值。透過了解 MMLU 的評估框架,企業和教育機構可以更好地利用 AI 技術,並更有效地評估和提升相關應用的效果。

6.1 企業應用場景

MMLU 的評估框架和方法可以應用於以下企業場景:

- 人才招聘評估: 企業可以使用基於 MMLU 評估框架設計的測試,來評估應徵者在特定領域的專業知識和解決問題的能力。相較於傳統的面試和筆試,這種方式更客觀、更有效率,可以幫助企業更快速地篩選出合適的人才。例如,對於需要專業知識的職位,如法律顧問、財務分析師等,可以使用相關領域的 MMLU 題目來評估應徵者的專業能力。

- 效益: 提高招聘效率、降低招聘成本、更客觀地評估應徵者能力。

- 挑戰: 需要設計與職位需求高度相關的題目、需要考慮到應徵者的隱私和公平性。

- 專業知識驗證: 企業可以使用 MMLU 評估框架來驗證員工或合作夥伴的專業知識水平,確保其具備必要的技能和知識。這對於需要高度專業知識的行業,如金融、醫療、法律等,尤為重要。例如,金融機構可以使用相關的 MMLU 題目來驗證員工對金融法規和市場知識的掌握程度。

- 效益: 確保員工和合作夥伴的專業素質、提高工作效率和品質、降低風險。

- 挑戰: 需要定期更新題目以反映最新的知識和技術、需要建立完善的驗證流程。

- 培訓系統開發: 企業可以利用 MMLU 的評估框架來開發更有效的培訓系統。透過分析員工在各個領域的表現,企業可以更有針對性地設計培訓內容,並追蹤培訓效果。例如,企業可以根據員工在 MMLU 相關測試中的薄弱環節,提供相應的培訓課程和資源。

- 效益: 提高培訓效率和效果、更有效地提升員工能力、降低培訓成本。

- 挑戰: 需要設計與培訓目標相符的評估題目、需要建立完善的培訓追蹤和反饋機制。

6.2 教育領域運用

MMLU 的評估框架和方法同樣可以應用於教育領域:

- 學習效果評估: 教師可以使用基於 MMLU 評估框架設計的測驗,來評估學生在各個學科的學習成效。這種方式可以更全面地了解學生對知識的掌握程度,並找出其學習上的弱點。例如,在歷史課上,教師可以使用相關的 MMLU 題目來評估學生對歷史事件和發展脈絡的理解。

- 效益: 更全面地評估學生的學習成效、更有效地追蹤學生的學習進度、提供更精確的教學反饋。

- 挑戰: 需要設計符合教學大綱和學習目標的題目、需要考慮到學生的個別差異。

- 個性化教學規劃: 透過分析學生在 MMLU 相關測驗中的表現,教師可以為學生制定更個性化的教學規劃。針對學生的薄弱環節,教師可以提供額外的輔導和資源,幫助學生更好地掌握相關知識。例如,如果學生在數學的某個概念上表現較弱,教師可以提供相關的練習題和講解,幫助學生加強理解。

- 效益: 提高教學效率和效果、更有效地滿足學生的個別學習需求、提升學生的學習動機。

- 挑戰: 需要建立完善的學生學習檔案和追蹤系統、需要投入更多的教學資源和時間。

- 能力診斷分析: 教育機構可以使用 MMLU 的評估框架來診斷學生的學習能力和潛力。透過分析學生在不同領域的表現,教育機構可以更全面地了解學生的優勢和劣勢,並為其提供更合適的教育和職業規劃建議。例如,教育機構可以根據學生在 MMLU 相關測驗中的表現,建議學生選擇更適合其能力的學科和專業。

- 效益: 更全面地了解學生的能力和潛力、提供更客觀的教育和職業規劃建議、幫助學生更好地發展。

- 挑戰: 需要建立完善的學生資料庫和分析系統、需要結合其他評估方法和工具。

7. 專家解答集

以下是一些關於 MMLU 測試的常見問題與解答,希望能幫助您更全面地了解 MMLU:

Q1:MMLU 測試結果如何應用於實際場景?

A:MMLU 測試結果具有廣泛的應用價值,可以應用於以下幾個方面:

- 評估 AI 系統的實際應用能力: MMLU 提供了一個標準化的評估框架,可以幫助企業和研究人員客觀地評估 AI 系統在不同知識領域的表現,了解其是否具備足夠的能力來處理實際應用中的複雜問題。例如,企業可以利用 MMLU 測試結果來選擇合適的 AI 模型,以應用於客戶服務、內容生成、數據分析等場景。

- 識別需要人類專家介入的領域: MMLU 測試結果可以幫助識別 AI 系統在哪些領域表現薄弱,需要人類專家介入才能完成任務。這有助於建立更有效的人機協作模式,充分發揮人類和 AI 各自的優勢。例如,在需要高度創意思維、道德判斷或複雜情境理解的任務中,人類專家仍然扮演著重要的角色。

- 制定 AI 應用的風險控制策略: 透過了解 AI 系統在 MMLU 測試中的表現,企業可以更有效地評估 AI 應用可能帶來的風險,並制定相應的風險控制策略。例如,如果 AI 系統在某些專業領域的表現不夠穩定或可靠,企業就需要謹慎評估其在這些領域的應用,並採取必要的監控和干預措施。

- 指導 AI 模型的改進和優化: MMLU 測試結果可以為 AI 模型的研究和開發提供重要的反饋。透過分析模型在各個領域的表現,研究人員可以找出模型的不足之處,並針對性地進行改進和優化。例如,如果模型在某個特定學科的表現較差,研究人員就可以針對該學科的知識和推理方式進行研究,並改進模型的架構和演算法。

Q2:如何提升 AI 在 MMLU 測試中的表現?

A:提升 AI 在 MMLU 測試中的表現需要從多個方面入手:

- 強化深度學習架構: 開發更先進的深度學習架構,例如 Transformer 模型的改進版本、更有效的注意力機制、更複雜的網路結構等,以提高模型的學習能力和推理能力。

- 擴充專業知識庫: 擴充模型的訓練數據,包含更廣泛、更深入的專業知識,使模型能夠更好地理解和應用不同領域的知識。這包括收集更多高品質的文本資料、構建更完善的知識圖譜等。

- 優化跨領域知識整合能力: 研究更有效的跨領域知識整合方法,使模型能夠更好地將不同領域的知識聯繫起來,並應用於解決複雜的問題。例如,可以探索使用多模態學習、知識遷移學習等技術。

- 改進模型的推理和泛化能力: 除了單純的知識儲存,更重要的是提高模型的推理和泛化能力,使其能夠根據已有的知識推斷出新的結論,並應用於未見過的情境。這需要研究更有效的推理演算法和訓練方法,例如使用強化學習、元學習等技術。

- 使用更有效的訓練策略: 使用更有效的訓練策略,例如 curriculum learning、self-training 等,可以幫助模型更好地學習和掌握知識。

Q3:MMLU 測試的局限性是什麼?

A:MMLU 測試雖然是一個重要的評估基準,但也存在一些局限性:

- 無法完全模擬實際應用場景: 雖然 MMLU 的題目設計注重實際應用,但畢竟是在一個受控的環境下進行的測試,無法完全模擬真實世界中複雜多變的應用場景。例如,MMLU 的題目通常是靜態的文本,而真實世界中的應用場景可能涉及多種模態的資訊,例如圖像、聲音、影片等。

- 評估標準可能存在主觀性 (在某些方面): 雖然 MMLU 主要採用選擇題的評分方式,以確保客觀性,但在某些需要判斷推理過程或回答開放性問題的情況下,評估標準可能仍然存在一定的主觀性。

- 更新週期較長 (相對於技術發展速度): 由於 MMLU 的題目需要經過嚴格的設計和審核,其更新週期可能相對較長,難以及時反映 AI 技術的最新發展。這可能導致 MMLU 測試在評估最新模型時存在一定的滯後性。

- 可能存在數據洩漏或重疊: 由於大型語言模型的訓練數據通常包含大量的公開文本,而 MMLU 的題目也可能來自這些文本,因此可能存在數據洩漏或重疊的情況,導致模型在測試中取得虛高的分數。這是一個需要關注和解決的問題。

- 對提示的敏感性: MMLU 對所使用的確切提示非常敏感,這可能會導致性能因提示而產生顯著差異。這使得比較不同模型在 MMLU 上的表現變得更加複雜。

- 缺乏對模型「理解」的直接評估: MMLU 主要評估模型回答問題的準確性,而無法直接評估模型是否真正「理解」了問題的含義。模型可能只是通過學習大量的數據來模仿人類的語言行為,而沒有像人類一樣的真正理解。