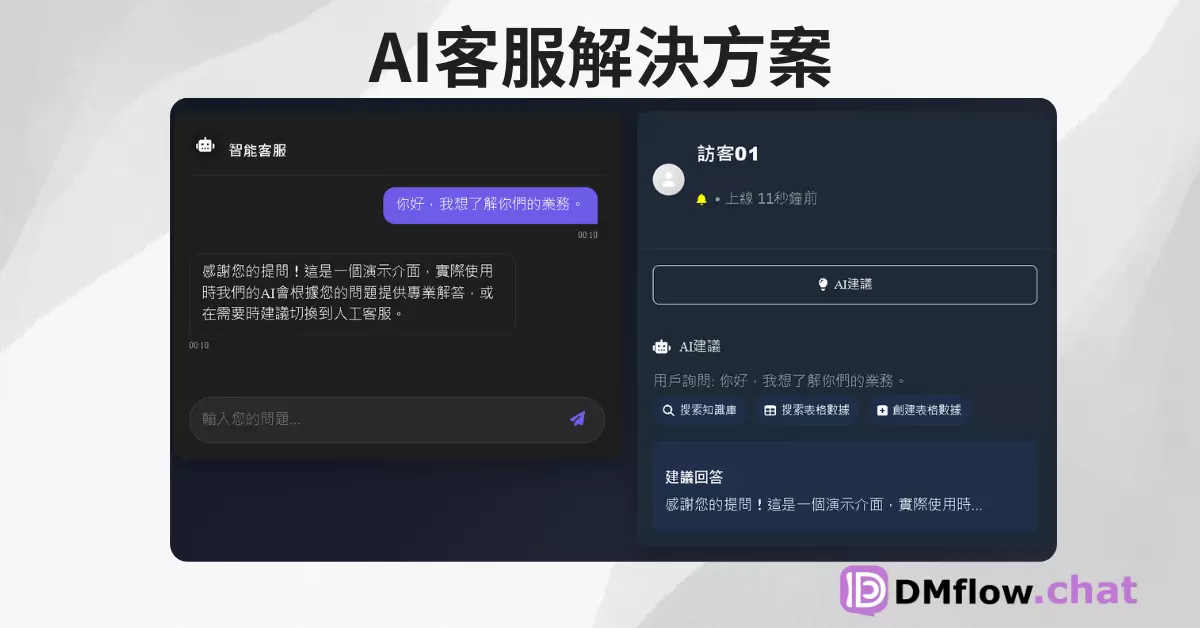

DMflow.chat

廣告

DMflow.chat:智慧客服新時代,輕鬆切換真人與 AI!持久記憶、客製欄位、即接資料庫表單,多平台溝通,讓服務與行銷更上一層樓。

探索 Magic 公司在 100M 代幣上下文窗口的突破性研究,以及與 Google Cloud 的合作。了解超長上下文模型如何改變 AI 學習方式,以及它們在軟體開發領域的應用前景。

圖片來自:https://magic.dev/blog/series-a

圖片來自:https://magic.dev/blog/series-a

人工智慧(AI)學習方式正在經歷重大變革。傳統上,AI 模型主要通過兩種方式學習:訓練和推理時的上下文學習。然而,隨著超長上下文窗口的出現,這種格局可能發生巨大變化。

Magic 公司的長期記憶(LTM)模型能夠在推理過程中處理高達 1 億個代幣的上下文,這相當於約 1000 萬行代碼或 750 本小說的內容量。這種能力為 AI 在軟體開發領域帶來了革命性的可能性。

想像一下,如果 AI 模型能夠將您的所有代碼、文檔和庫(包括那些不在公共互聯網上的)都納入上下文,代碼合成的質量將會有多大提升。這不僅能提高開發效率,還能大幅減少錯誤和提高代碼質量。

傳統的長上下文評估方法存在一些問題。例如,常見的「大海撈針」評估方法將隨機事實(針)放在長上下文窗口(大海)中間,並要求模型檢索該事實。然而,這種方法可能導致模型學會識別異常信息,而不是真正理解和處理長上下文。

為了解決這個問題,Magic 公司設計了一種新的評估方法:HashHop。這種方法使用哈希對來測試模型的存儲和檢索能力,確保模型能夠處理最大可能的信息內容。

HashHop 的具體步驟如下:

這種方法不僅能評估模型的單步推理能力,還能測試多步推理和跨上下文推理的能力,更貼近實際應用場景。

Magic 公司最近訓練了他們的首個 1 億代幣上下文模型:LTM-2-mini。這個模型在處理長上下文方面表現出色,特別是在效率和內存需求方面遠超傳統模型。

LTM-2-mini 的主要優勢包括:

LTM-2-mini 在代碼合成方面也展現了潛力,儘管其規模遠小於當前的頂尖模型,但在某些任務中仍能產生合理的輸出,如使用自定義 GUI 框架創建計算器和實現密碼強度計。

為了進一步推進其研究和開發,Magic 公司與 Google Cloud 建立了戰略合作夥伴關係。這項合作的主要內容包括:

這項合作將大大提高 Magic 公司的推理和訓練效率,並為其提供快速擴展和豐富的雲服務生態系統。

隨著 Magic 公司在其新的超級計算機上訓練更大規模的 LTM-2 模型,我們可以期待看到更多令人興奮的突破:

這些進展不僅將推動 AI 技術的發展,還可能為各行各業帶來革命性的變化。

Q: 什麼是超長上下文窗口,它為什麼重要? A: 超長上下文窗口允許 AI 模型在推理過程中處理大量信息,如 Magic 的 LTM 模型可處理高達 1 億個代幣的上下文。這對於提高 AI 在複雜任務中的表現至關重要,特別是在軟體開發等需要大量上下文信息的領域。

Q: Magic 公司的 LTM-2-mini 模型有什麼特點? A: LTM-2-mini 是一個能夠處理 1 億代幣上下文的模型,其序列維度算法比傳統模型效率高得多,內存需求也大大降低。它在 HashHop 評估中表現出色,並展示了在代碼合成方面的潛力。

Q: Magic 公司與 Google Cloud 的合作會帶來什麼影響? A: 這項合作將使 Magic 公司能夠利用 Google Cloud 的強大計算資源和 AI 工具,加速其模型的訓練和部署。這可能會導致更強大、更高效的 AI 模型的快速發展,推動整個 AI 行業的進步。

Q: 超長上下文模型對軟體開發有什麼潛在影響? A: 這些模型可能徹底改變代碼合成和軟體開發流程。它們能夠理解和操作更大的代碼庫,提供更準確的建議和自動化更複雜的編程任務,從而大幅提高開發效率和代碼質量。

Q: HashHop 評估方法有什麼優勢? A: HashHop 通過使用隨機且不可壓縮的哈希來評估模型的存儲和檢索能力,避免了傳統評估方法中的隱含語義提示問題。這種方法更能反映模型在實際應用中的表現,特別是在需要多步推理的複雜任務中。

DMflow.chat:智慧客服新時代,輕鬆切換真人與 AI!持久記憶、客製欄位、即接資料庫表單,多平台溝通,讓服務與行銷更上一層樓。

xAI推出Grok-2測試版:X平台的全新AI革命 xAI最新推出的Grok-2和Grok-2 mini語言模型為X平台帶來了革命性的變革。本文深入探討這些先進AI模型的特點、性能及其對用戶體...

微軟 BitNet b1.58 震撼登場:跑更快、更省電的 1 位元 AI 模型來了? AI 發展快到讓人眼花撩亂,但模型的「食量」也越來越驚人?來看看微軟最新的 BitNet b1.5...

限時七天!Windsurf AI 震撼推出免費無限 GPT-4.1 試用,立即體驗頂尖 AI!(2025-0414-0421) AI 界的朋友們注意!Windsurf AI 宣布提供為期...

偷聽海豚說話?Google AI 神器 DolphinGemma 揭開海洋世界的溝通秘密 幾十年來,科學家們一直試圖解開海豚那複雜的「喀答聲」、「哨聲」和「脈衝聲」之謎。現在,Googl...

WordPress 放大絕!一句話打造專屬網站?AI 助手讓你跟架站煩惱說掰掰! 厭倦了複雜的網站架設流程?WordPress 推出革命性 AI 網站建置工具,只要一句話描述你的想法,A...

AI 智慧體大串連!Google 推出開源 A2A 協定,打造無縫協作新時代 厭倦了各自為政的 AI 工具嗎?Google 攜手 50 多家科技巨頭推出 Agent2Agent (A2A...

TikTok 大規模裁員:AI內容審核時代來臨,全球數百員工受影響 文章摘要 TikTok近期宣布全球性裁員計畫,以加速AI內容審核的發展。本文深入分析裁員原因、影響範圍,以及對社群媒體行業的...

GenSFX:AI 音效產生器 - 將文字化為聲音 GenSFX 是一款強大的 AI 音效產生器,讓您透過簡單的文字描述,就能創造出您需要的音效。其強大的功能和便利性仍然值得關注。 ...

AI 當導演?SkyReels-V2 讓無限長度電影成真! 厭倦了 AI 影片只有幾秒鐘?來看看 SkyworkAI 的 SkyReels-V2,這個模型能生成無限長度的電影級影片,還能...

By continuing to use this website, you agree to the use of cookies according to our privacy policy.