DMflow.chat

廣告

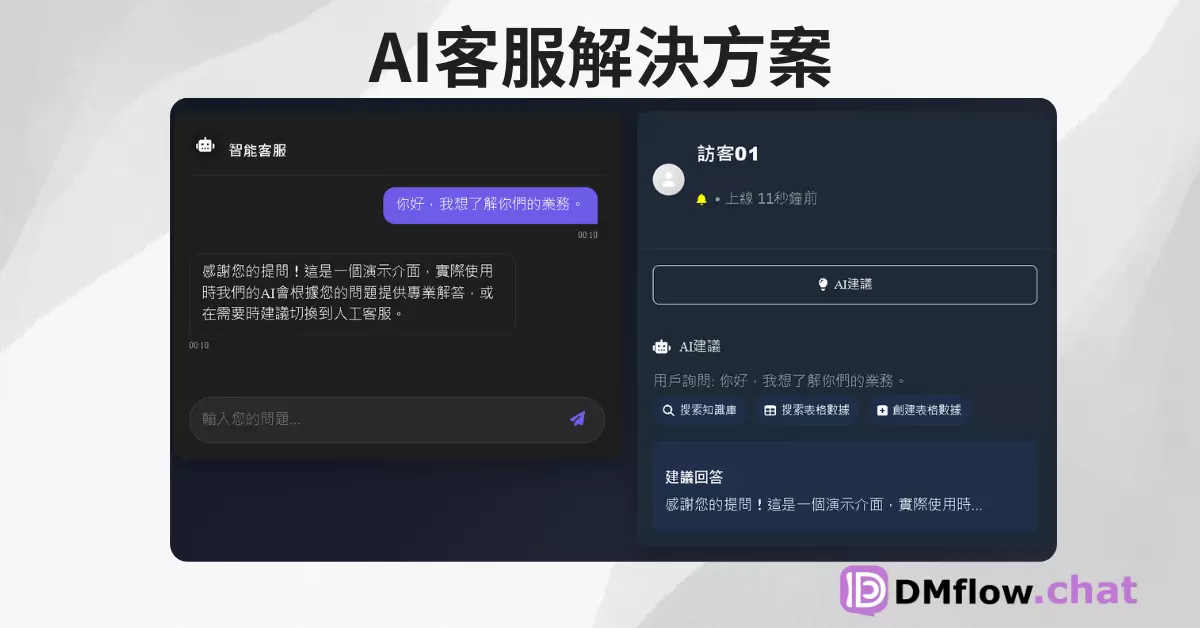

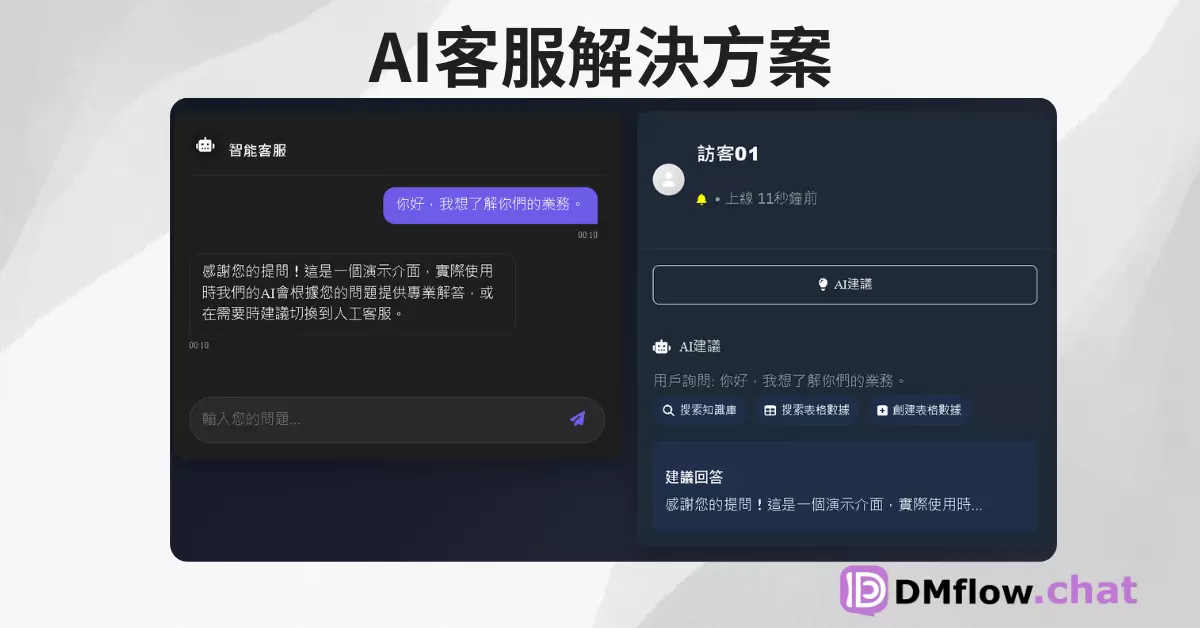

一站整合多平台聊天,體驗真人與 AI 自由切換的新境界!支援 Facebook、Instagram、Telegram、LINE 及網站,結合歷史記錄、推播通知、行銷活動及客服轉接,全面提升效率與互動。

探索 OpenAI 最新的 GPT-4.1 模型,學習如何透過優化提示詞 (Prompt) 來駕馭其強大的程式編寫、指令遵循和長文本處理能力。本指南將分享實用的技巧和範例,助您充分發揮 GPT-4.1 的潛力。

此文章為官方釋出GPT-4.1 Prompting Guide簡化版,若需要完整文章請閱讀此。

嘿,各位 AI 玩家和開發者們!OpenAI 又放大招了,推出了 GPT-4.1 系列模型。跟之前的 GPT-4o 相比,它在寫程式碼、理解指令,還有處理超長文件方面,簡直是跳了一大級。是不是很興奮?

不過,俗話說得好,「工欲善其事,必先利其器」。要讓這位新來的「高手」發揮十成功力,得學會怎麼跟它溝通,也就是所謂的「提示詞工程」(Prompt Engineering)。

這篇文章就是你的武功秘笈!整理了大量內部測試的心得,就是要幫你掌握駕馭 GPT-4.1 的訣竅。

等等,舊的提示詞技巧還管用嗎?

很多老方法依然有效,像是給它一些範例參考(Context Examples)、指令越清楚具體越好、引導它先「思考規劃」再行動等等。這些都能讓模型變得更聰明。

但!請注意,GPT-4.1 有個重要的轉變:它比前輩們更「聽話」,會更嚴格、更照字面意思來遵循你的指令。以前的模型可能比較會「猜」你想幹嘛,但 GPT-4.1 就比較一板一眼。

這有好有壞。好處是,只要你的指令夠明確,它就能被精準地引導;壞處是,如果你期望它像以前一樣「心領神會」,那結果可能會出乎意料。不過別擔心,通常只要補上一句堅定且毫不含糊的指令,就能把它導回正軌。

接下來,會分享一些實用的提示詞範例,但請記得,AI 工程是門實驗科學,沒有萬能丹。最重要的還是要多方嘗試、建立有效的評估機制,並持續迭代,才能找到最適合你應用場景的方法。

準備好了嗎?讓開始探索 GPT-4.1 的提示詞魔法吧!

你知道嗎?GPT-4.1 非常適合用來打造所謂的「代理式工作流程」(Agentic Workflows)。簡單來說,就是讓 AI 不只回答單一問題,而是能自主執行一系列步驟來完成更複雜的任務,就像一個小助理一樣。

在訓練 GPT-4.1 時,特別強化了它解決問題的「代理」能力。事實上,在針對軟體工程任務的 SWE-bench 測試中,的代理式設定解決了高達 55% 的問題,這在非推理模型中可是頂尖水準!

打造得力助手的三個「咒語」

為了讓 GPT-4.1 的代理能力全開,強烈建議在所有「代理提示詞」中加入以下三種關鍵提醒。雖然下面的範例是針對寫程式碼的場景優化,但稍作修改就能應用於其他代理任務:

效果驚人!

說出來你可能不信,單單加上這三條簡單的指令,內部在 SWE-bench 測試上的分數就提高了將近 20%!這讓模型從一個比較被動的聊天機器人,轉變成一個更「積極」、能自主推動任務的代理。所以,強烈建議大家從這三點開始打造你的代理提示詞。

關於「工具呼叫」的小提醒

跟以前的模型比,GPT-4.1 在使用 API 中 tools 欄位傳遞的工具方面,受過更多訓練。鼓勵開發者只用這個 tools 欄位來提供工具,而不是像以前有些人會把工具描述手動塞進提示詞裡,然後再自己寫解析器。

為什麼?因為使用標準的 tools 欄位是減少錯誤、確保模型在執行工具呼叫時表現穩定的最佳方式。的實驗也證明,使用 API 解析的工具描述,比起手動注入到系統提示詞中,SWE-bench 的通過率提高了 2%。

給工具取個好名字,並在 description 欄位提供清晰、詳細的描述。同樣地,工具的每個參數也要有好名字和好描述。如果你的工具特別複雜,想提供使用範例,建議在系統提示詞裡開一個 # Examples 區塊放範例,而不是塞在 description 裡。範例可以幫助模型了解何時該用工具、是否要連同使用者文字一起呼叫、以及針對不同輸入該用哪些參數。

讓模型「大聲思考」:誘導式規劃與思維鏈

前面提到,你可以選擇性地讓 GPT-4.1 代理在工具呼叫之間進行規劃和反思。雖然 GPT-4.1 本身不是「推理模型」(它不會在回答前產生內部的思考鏈),但你可以透過類似上面「Planning」的提示詞,誘導它在輸出中明確地一步步展示其思考過程,就像「大聲思考」一樣。

在的 SWE-bench 代理任務實驗中,誘導明確的規劃讓通過率提升了 4%。這在處理複雜問題時特別有用,能讓你更清楚模型是怎麼「想」的。

GPT-4.1 的另一個亮點是它強大的長文本處理能力,輸入窗口高達 100 萬個 token!這代表什麼?你可以把超長的文件、大量的程式碼、或者一整本書的內容丟給它,讓它幫你:

長文本雖好,但也要注意

雖然 GPT-4.1 在「大海撈針」的測試中表現優異(即使在 100 萬 token 的極限下),處理混合了相關和不相關資訊的複雜任務也很在行,但有幾點要注意:

調整模型對「外部知識」的依賴

有時候,你希望模型嚴格只根據你提供的文本來回答,避免它「自由發揮」;有時候,你又希望它能結合自身的知識來補充或連結資訊。你可以透過指令來調整:

# Instructions

// for internal knowledge

- 只能使用提供的外部內容 (External Context) 來回答使用者查詢。如果你根據此內容不知道答案,即使使用者堅持要你回答,你也必須回應「我沒有回答所需的資訊」。

# Instructions

// For internal and external knowledge

- 預設使用提供的外部內容來回答使用者查詢,但如果回答需要其他基本知識,且你對答案有信心,你可以使用一些自己的知識來協助回答。

提示詞的「擺放藝術」

尤其在處理長文本時,指令和內容的擺放位置會影響效果。的經驗是:

記住這個小技巧,能幫助模型更好地抓住重點!

前面提過,GPT-4.1 不是天生的「推理模型」,但可以透過提示詞引導它進行「思維鏈」(Chain of Thought, CoT),也就是讓它在回答前先一步步把問題拆解、思考、分析。

這有什麼好處?能顯著提升輸出的品質和準確性,尤其對複雜問題。代價是會消耗更多輸出 token,成本和延遲會高一些。好消息是,GPT-4.1 本身在代理推理和解決實際問題方面訓練得不錯,通常不需要太費力的提示就能做得很好。

基礎 CoT 指令:

可以在提示詞的末尾加上這句簡單的指令作為起點:

...

首先,仔細逐步思考需要哪些文件來回答查詢。然後,打印出每個文件的標題 (TITLE) 和 ID。接著,將這些 ID 格式化成一個列表。

進階 CoT 策略:

如果基礎版效果不彰,你可以觀察模型在你的特定範例或評估中是怎麼「想錯」的,然後用更明確的指令來修正它的規劃或推理錯誤。例如,如果發現模型容易誤解使用者意圖,或沒有充分分析上下文,可以加入更詳細的推理策略:

# Reasoning Strategy

1. 查詢分析 (Query Analysis): 分解並分析查詢,直到你確信理解其意圖。利用提供的上下文來釐清任何模糊或令人困惑的資訊。

2. 上下文分析 (Context Analysis): 仔細選擇並分析一大組可能相關的文件。優先考慮召回率 (recall) - 有些不相關也沒關係,但正確的文件必須在這個清單中,否則最終答案會是錯的。每個文件的分析步驟:

a. 分析 (Analysis): 分析該文件與回答查詢的相關性(或不相關性)。

b. 相關性評分 (Relevance rating): [高, 中, 低, 無]

3. 綜合 (Synthesis): 總結哪些文件最相關及其原因,包含所有相關性評分為中或更高的文件。

# User Question

{user_question}

# External Context

{external_context}

首先,仔細逐步思考需要哪些文件來回答查詢,嚴格遵守提供的推理策略 (Reasoning Strategy)。然後,打印出每個文件的標題 (TITLE) 和 ID。接著,將這些 ID 格式化成一個列表。

關鍵在於觀察、迭代,找出最適合你需求的 CoT 提示方式。

GPT-4.1 最令人印象深刻的特點之一,就是它出色的「指令遵循」能力。這意味著開發者可以非常精確地塑造和控制模型的輸出,滿足各種特定需求,像是:

但正如前面提到的,它的「字面化」意味著你需要更明確地指示它「該做什麼」和「不該做什麼」。如果你把之前為其他模型優化的提示詞直接搬過來,可能會發現效果不如預期,因為 GPT-4.1 會更嚴格地遵循現有指令,而不太會去推斷那些「潛規則」。

指令開發與除錯流程建議:

# Sample Phrases(範例語句)。常見的「翻車」場景(不只 GPT-4.1 有):

一路看下來,你可能想問,到底一個「好」的提示詞長什麼樣?這裡提供一個不錯的起始結構,你可以根據需求增刪調整:

# 角色與目標 (Role and Objective)

# 指令 (Instructions)

## 更詳細指令的子分類 (Sub-categories for more detailed instructions)

# 推理步驟 (Reasoning Steps)

# 輸出格式 (Output Format)

# 範例 (Examples)

## 範例 1 (Example 1)

# 上下文 (Context)

# 最終指令與逐步思考提示 (Final instructions and prompt to think step by step)

選對「分隔符」,事半功倍

用什麼符號來區分提示詞的不同部分也很重要。

# 做標題(支援多層級),用 ` ` 或 <examples>

<example type="Abbreviate">

<input>San Francisco</input>

<output>- SF</output>

</example>

</examples>

針對大量文件/長文本的特別建議:

例:<doc id=1 title=”狐狸”>敏捷的棕色狐狸跳過懶狗</doc>例:ID: 1 | TITLE: 狐狸 | CONTENT: 敏捷的棕色狐狸跳過懶狗總之,選擇分隔符的原則是:清晰、能讓模型「一眼看到」重點。例如,如果你提供的上下文裡本身就有很多 XML,那再用 XML 做分隔符效果可能就打折扣了。

一些小提醒 (Caveats):

parallel_tool_calls 參數設為 false。GPT-4.1 無疑是個強大的工具,但要真正發揮它的潛力,關鍵在於「提示詞」。記住,它更像一個嚴格遵循食譜的廚師,而不是一個會讀心術的大師。

希望這份指南能幫助你更好地駕馭 GPT-4.1,創造出更驚豔的應用!

一站整合多平台聊天,體驗真人與 AI 自由切換的新境界!支援 Facebook、Instagram、Telegram、LINE 及網站,結合歷史記錄、推播通知、行銷活動及客服轉接,全面提升效率與互動。

OpenAI 再出招!全新 o3、o4-mini 模型登場,讓 AI 不只會答,更會「想」! OpenAI 推出了最新的 o 系列 AI 模型:o3 和 o4-mini。它們不僅更聰明、...

告別金魚腦!ChatGPT 推出記憶功能,讓你的 AI 對話體驗大升級 OpenAI 為 ChatGPT Plus/Pro 用戶悄悄推出「記憶」功能,讓 AI 不再健忘,能記住你的偏好,...

OpenAI Academy:解鎖 AI 新時代,與全球專家、社群一同學習成長 踏入 AI 領域不再遙不可及!OpenAI Academy 提供一個充滿活力的學習環境,讓你與頂尖專家和創...

OpenAI 推出 GPT-4o 圖像生成功能,支援多輪對話編輯 OpenAI 於 2025 年 3 月 25 日宣布,最新的 GPT-4o 模型現已支援圖像生成與多輪對話編輯,帶來更強大的 ...

ChatGPT 搜尋免登入上線:Google 搜尋會受到怎樣的影響? 近期 OpenAI 在 ChatGPT.com 推出一項新功能,讓使用者可以不用登入就能使用 ChatGPT 搜尋。...

Deep Research:ChatGPT 革命性研究功能全面解析 引言:AI 研究助理的新紀元 在當今快速發展的科技世界中,資訊獲取和深度研究變得越來越重要。OpenAI 推出的 D...

Stable Fast 3D:革命性單圖3D模型生成技術 Stability AI推出突破性技術Stable Fast 3D,只需0.5秒即可從單一圖像生成高品質3D資產。這項創新為遊戲開發、...

Botpress:解鎖AI聊天機器人的無限可能 在這個數位化時代,聊天機器人已成為企業與客戶溝通的重要工具。而Botpress作為一個開源的聊天機器人平台,正在引領這場革命。本文將深入探討Bo...

ChatGPT模型演進:從3.5到4.0,再到4o和4o mini的全面比較 本文深入剖析了OpenAI的ChatGPT系列模型,從ChatGPT-3.5到ChatGPT-4,再到最新的Cha...

By continuing to use this website, you agree to the use of cookies according to our privacy policy.